記事内容

【お知らせ】内容のリライトに伴い、データクリーニング作業に関しては、2025年8月時点のPower BI Desktopを用いて再作業しています。また、最後にExcelとの使い分けについての考察を追記しました。

センサーでデータ活用!収集から分析まで「やってみた」

データ活用ついて語る上では、実際に取り組んで実感する必要があると考えました。内容としては、センサーで収集したデータを分析する作業を3つの観点から、それぞれのコラム記事でご紹介しています。

[1]センサーによるデータ収集

[2]データ分析前のデータクリーニング

(ここ)「BIツールを活用したデータクリーニングでデータ整理」

[3]データ分析を通じてデータ活用を実践

なお、これら3つのコラム記事に共通する概念を整理した上で、個別の内容に入ります。

- データ収集:センサーなどを用いて生データを得るプロセス

- データ分析:収集したデータを加工・集計し、パターンや傾向、示唆を見出すプロセス(データ収集の直接的な次のステップ)

- データ活用:データ収集とデータ分析のプロセスを通じて得られた情報から、ビジネス上の課題解決、意思決定支援、新たな価値創造を実現する、より広範で本質的な目的とプロセス

データ分析におけるデータクリーニングの重要性

データ分析やデータ活用を進める上で、事前のデータクリーニング(またはデータクレンジング)という作業は欠かせません。これは収集したデータに適用される作業であり、データの質を高めるために実施する一連の作業を指します。具体的には、次のような処理が含まれます。

- 欠損値や空欄、不要なデータの特定と除去

- 入力ミスや異常値、重複レコードの修正・統合

- フォーマットの統一(例:日付や住所、表記ゆれの修正)

- 外れ値や不整合のチェックと是正

- 必要に応じてデータを標準化・正規化し、分析やシステムで扱いやすい形へ整形

こうした工程によって、データの信頼性と一貫性が確保され、正確な分析結果や意思決定につなげることができます。

例えば収集したデータに無効なデータ、例として空の値(null値)などが含まれていると、グラフ作成のようなデータ分析を行う際に不都合が生じます。データ分析に用いるためには、有効な値のみで構成された表に整理するデータクリーニング作業が必須となります。

このデータクリーニング作業は、BIツール(Business Intelligenceツール)を活用することで効率的に行うことが可能です。BIツールは、企業などの組織データを収集・蓄積・分析・報告することで企業の意思決定に役立てる手法や技術であるBI[1]の実現を、専門家の力を借りることなく支援するツールです。BIツールは、迅速なレポート出力、データを分かりやすく可視化、データマイニング[2]、シミュレーションといった多様な機能を備えています。

センサーデータを対象としたデータクリーニングの具体例

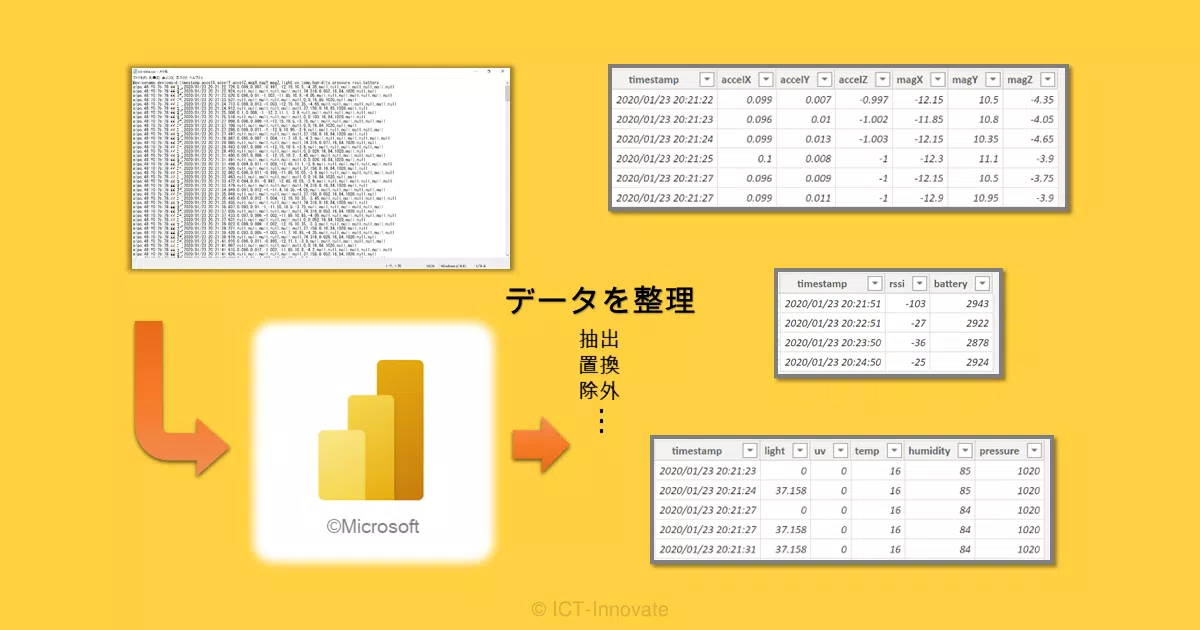

当コラム記事でデータクリーニングの実例として用いるのは、データ収集のコラム記事でご紹介した「センサーデータ収集ツール」が出力するCSVファイルです。マルチセンサー[3]が計測・送信したデータを含んだこのCSVファイルには、以下のような特徴があります。

- 時系列に送信されたデータレコードがCSVファイルの行データとなり、(全ての)データ項目が列データとなる

- マルチセンサーは、一度に全てのデータ項目を送信するのではなく、部分的に個別のタイミングで送信する

具体的には、データの送信タイミングが3パターンあり、それぞれのデータ項目は次のようになります。

- モーション系センサー:加速度、地磁気

- 環境系センサー:温度、湿度、気圧、照度、紫外線

- ステータス通知:受信電波強度、電池電圧

この送信タイミングの違いにより、CSVファイルを一つの表として見た場合、空の値(null値)が含まれることになります。例えば、モーション系センサーから送信されたデータレコード(行)では、モーション系センサーのデータ項目(列)のみ計測値が入り、他のデータ項目は空の値となります。つまり、データ項目への値の入り方を全体俯瞰で見ると「虫食い状態」のようになっているのです。

したがって、「センサーデータ収集ツール」が出力するCSVファイルの例においては、データクリーニング作業として、行も列も対象としてデータを整形し直すことにより、空の値を含まない3つの表(データテーブル)に整理することが目標となります。

これは一例に過ぎませんが、収集データの中に無関係なデータや形式の異なるデータ、無効な値が存在する場合に不要なデータを除外するという、一般的なデータクリーニングの目的に合致します。

Power BI Desktopでのデータクリーニング実践

それでは、BIツールを使ったデータクリーニング実践を通じて、データ分析の精度向上にいかに貢献するかを実感いただきたいと思います。

当コラム記事ではBIツールとして、無料から使用できるMicrosoftのPower BI[4](具体的にはPower BI Desktop)をデータクリーニング作業に用います。ExcelやPowerPointといったMicrosoft製品を使い慣れている利用者であれば、似た操作感でデータ分析を行うことができます。また、「Power Query エディター」がいかに強力なツールであるかを具体例とともにご紹介します。

なお、あらかじめお伝えしておきますが、Microsoft Power BI製品のご紹介が目的ではありませんので、製品自体の説明には余り踏み込みません。Microsoft社の学習資料から、Power BI全体の概要とPower BI Desktopのチュートリアルをご紹介しますので、ご興味がある方はこちらを参照ください。

「Power BI 入門ドキュメント」

https://learn.microsoft.com/ja-jp/power-bi/fundamentals/

(2025/8/29 引用)

「Power BI Desktop の概要」

https://learn.microsoft.com/ja-jp/power-bi/fundamentals/desktop-getting-started

(2025/8/29 引用)

また、以降の作業内容説明についても、主要な操作の流れが分かる程度の端折った説明に留めています。より詳しい情報については、引用したチュートリアル上の該当部分を明示しますので、そちらをご参照ください。

それでは、具体的なデータクリーニング作業の内容に移ります。作業としては前述の通り、CSVファイルのデータを基にして、空の値を含まない3つのデータテーブルを得ることになります。Power BI DesktopでCSVファイルのデータを取得するところから、データを操作して結果を得るところまでを、順を追ってご説明します。

なお、Power BI Desktopにおけるデータ操作は、Power Query エディターで行うクエリ編集が該当しますので、この辺りが中心となります。因みに、Power Queryについては後述します。(最後の補足にて)

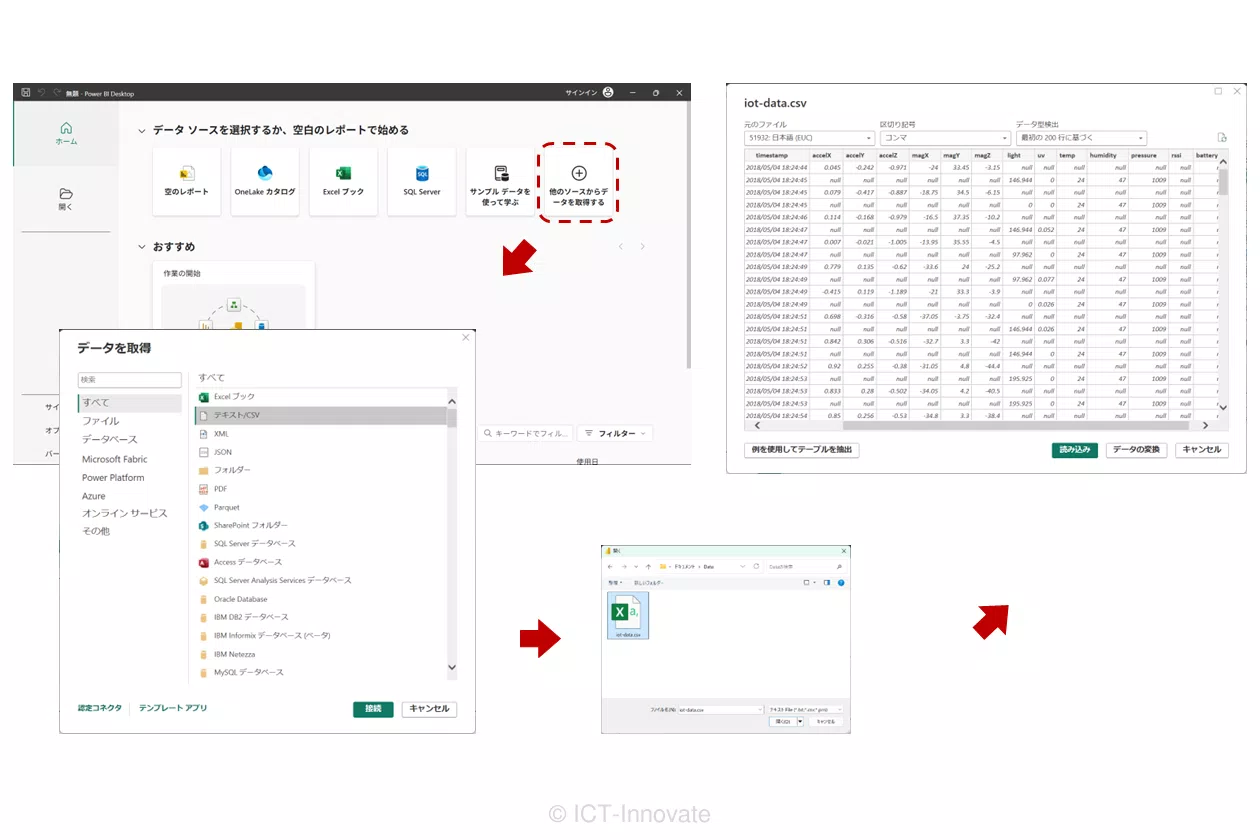

[1]データ取得

Power BI Desktopから対象のCSVファイルのデータに接続します。この辺りの詳細は、チュートリアルの「データに接続する」が該当します。方法は複数ありますが、ここではPower BI Desktop起動時の画面にて、「他のソースからデータを取得する」をクリックして一連の操作を開始します。操作の流れは下図の通りです。

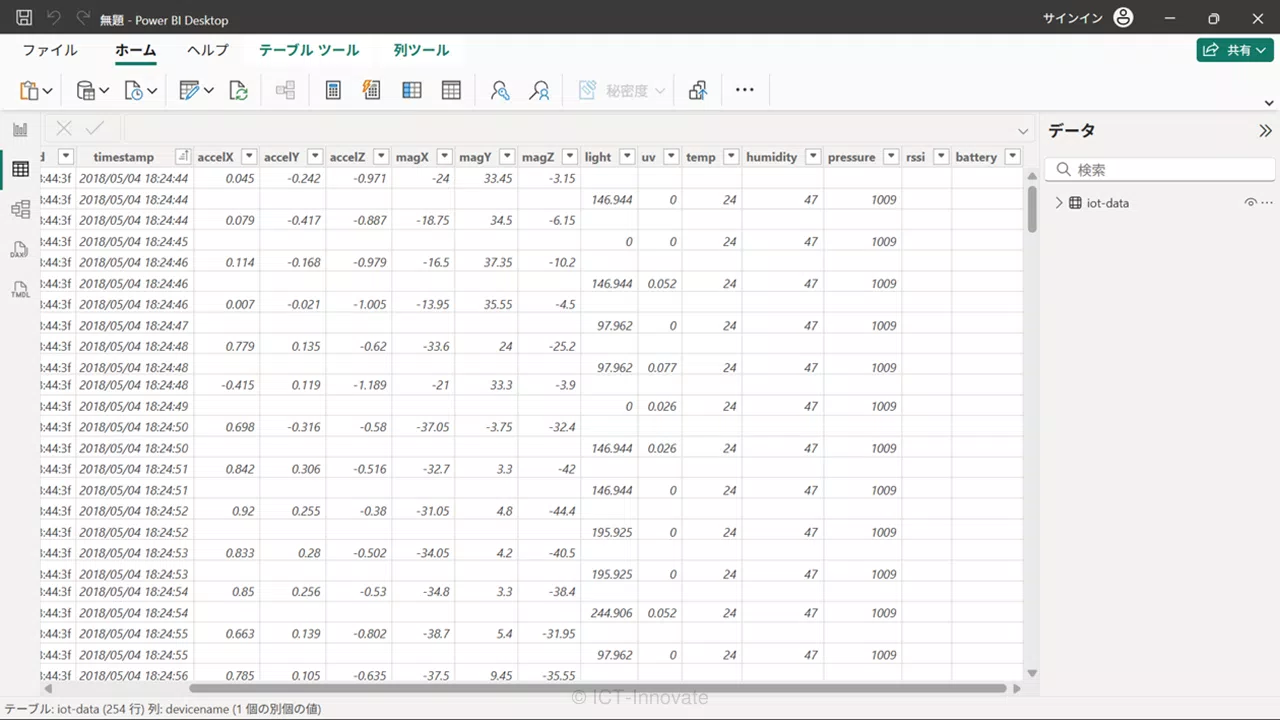

上図はデータ取得後のPower BI Desktop画面をデータビューの表示にしています。画面右(データ)「iot-data」の内容を可視化しています。

値の入り方を見ますと、マルチセンサーからの部分的な送信により、多くの空の値が散見される「虫食い状態」となっていることが一目瞭然です。この状態では、例えばグラフを作成しても正しい分析結果が得られません。次からのステップで、いかにこの「虫食い状態」を解消し、分析可能な形に整えていくか、実践していきます。

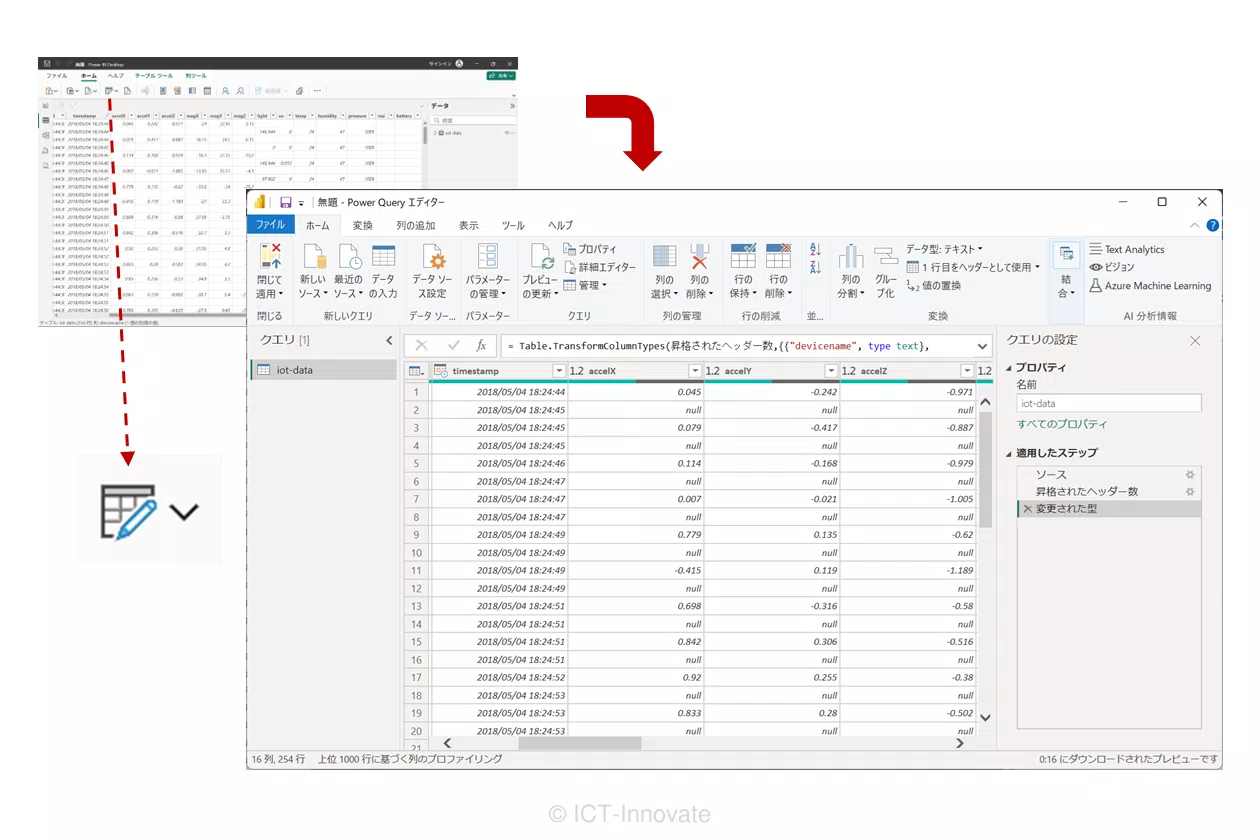

[2]Power Query エディターの起動

Power Query エディターは、データ分析におけるETL(抽出・変換・読み込み)処理の中心となる場所であり、収集したデータを分析に適した形に「変形」させるための重要な環境です。特に注目いただきたい点について、画面でご説明します。

Power Query エディターを起動します。なお、ここからPower Query エディターを閉じるまでの詳細は、チュートリアルの「データの整形」および「データの結合」(一部)が該当します。操作の流れは下図の通りです。

- 画面左(クエリ):作成したクエリの一覧表示(作業対象を選択する)

- 画面右(クエリの設定):選択されたクエリの「プロパティ」と「適用したステップ」を表示

- 画面中央:選択されたクエリの「適用したステップ」から、指定したステップ(データ操作)実行時点のデータ内容を表示

「クエリ」について補足します。ここでの「クエリ」は、データに対する一連の操作を、名前を付けて保存したものと捉えると分かりやすいと思います。

画面の情報で特に注目いただきたいのが、「適用したステップ」です。これは、データに対する全ての操作が、まるで調理のレシピのように自動で記録される機能です。これにより、どのステップでどのようなデータ変換が行われたかを後から詳細に確認したり、必要に応じて特定のステップを修正したりすることが非常に容易になります。試行錯誤しながらデータクリーニングを進めることができ、作業効率が大幅に向上するBIツールならではの強力な機能と言えるでしょう。

上図の「適用したステップ」に着目すると、一番上の「ソース」から3ステップ記録されています。まだデータの取得操作を行っただけですが、ソースへの接続からデータ型の変更までが自動で行われたことを示しているのです。

[3]クエリ編集

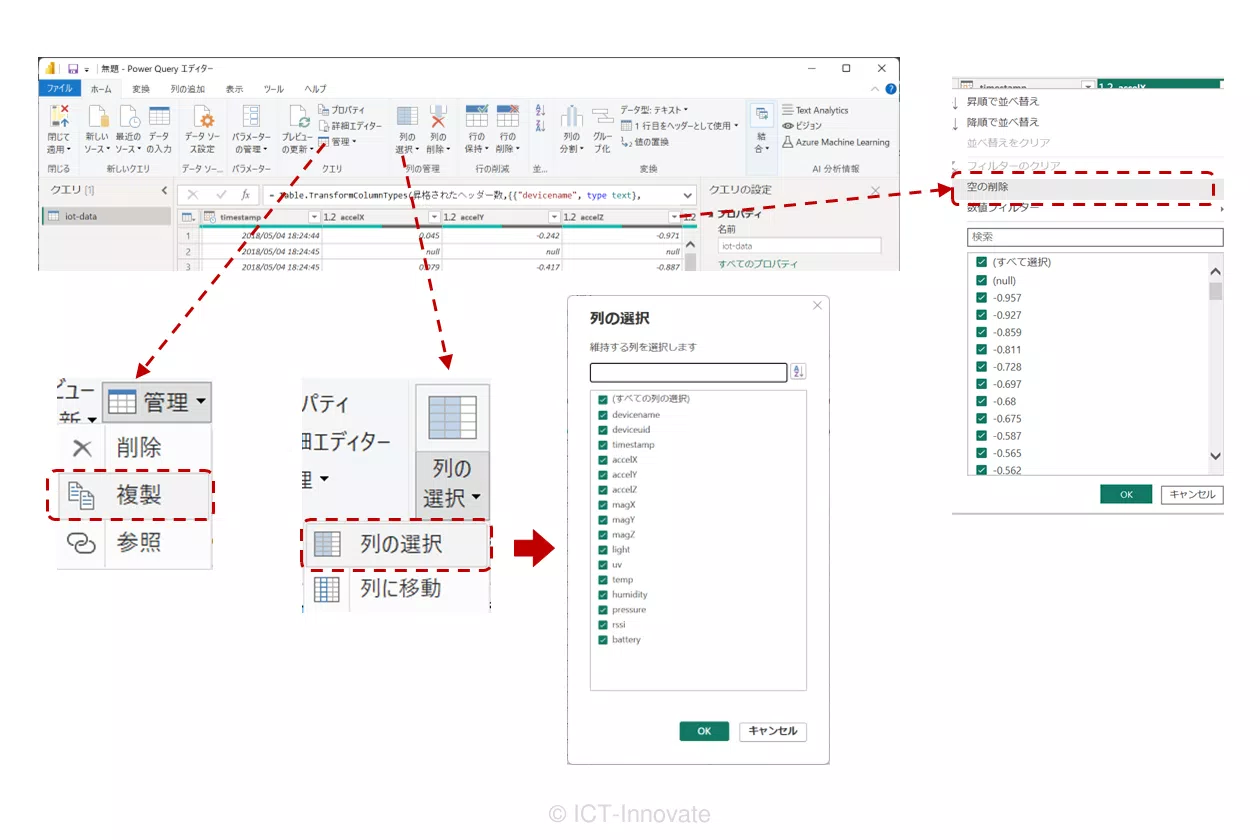

Power Query エディターで行うデータ操作作業を指します。下図(上側)は、当事例における操作の流れとなります。下図(下側)は、クエリ編集の結果となります。各操作および、結果についてご説明します。

「複製」

マルチセンサーからの送信データが3つの異なる種類(モーション、環境、ステータス)に分かれているため、それぞれのセンサーデータに特化した異なる整形を行う必要があります。つまり、3つのクエリ(motion、air、status)を用意するためにクエリの複製を行います。なお、クエリ名は「プロパティ」から編集できます。

「列の選択」

各クエリでは、それぞれのセンサーが送信したデータ項目のみを残し、後続の分析に不要な、あるいはそのセンサーグループとは関係のない列を整理します。例えば、「air」クエリでは、モーション系センサーの加速度や地磁気の列は不要となるため、これらを除外します。これにより、空の値を含む列は除外されます。

「空の削除」

図だと分かり辛いかもしれませんが、列のプルダウンからフィルター条件設定にて「空の削除」を指定します。これにより、各クエリに該当するセンサーのデータ項目が「空ではない」行のみを抽出します。この結果、本来のセンサーデータが存在しない空行や、他の種類のセンサーデータが送信されたタイミングの行が除去され、各クエリの結果は有効な値のみで構成される正確な分析の基盤となります。

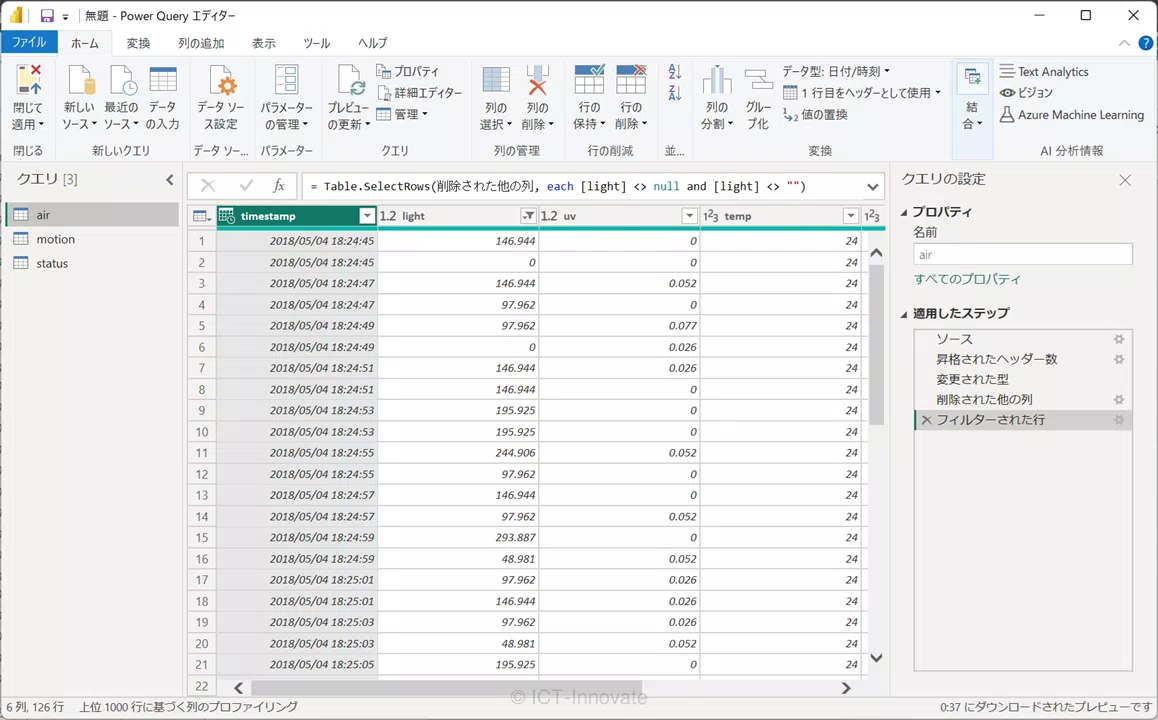

クエリ編集の結果画面に着目しましょう。3つのクエリが作成されています。そして、「air」クエリが選択されて情報表示されています。「適用したステップ」には5ステップ記録されています。クエリ編集前と比較してみましょう。5ステップの内、上から3ステップはクエリ編集前と同様であり、2ステップが新たに追加されていることが分かります。

3ステップまでについては、クエリの複製により、複製元のステップを複製した形になります。「適用したステップ」にはデータに対する操作が反映されるのです。よって、クエリ名の変更はステップには反映されません。そして、列に対する操作(列の選択)と、行に対する操作(空の削除)は、それぞれステップに反映されています。

クエリ編集を通じて、「適用したステップ」には一連の作業が、まるでレシピのように自動で記録されます。これにより、どのステップでどのようなデータ変換が行われたかを後から詳細に確認でき、また、もし途中で意図しない結果になった場合でも、簡単に過去のステップに戻って修正できるため、安心してデータクリーニングを進めることができます。

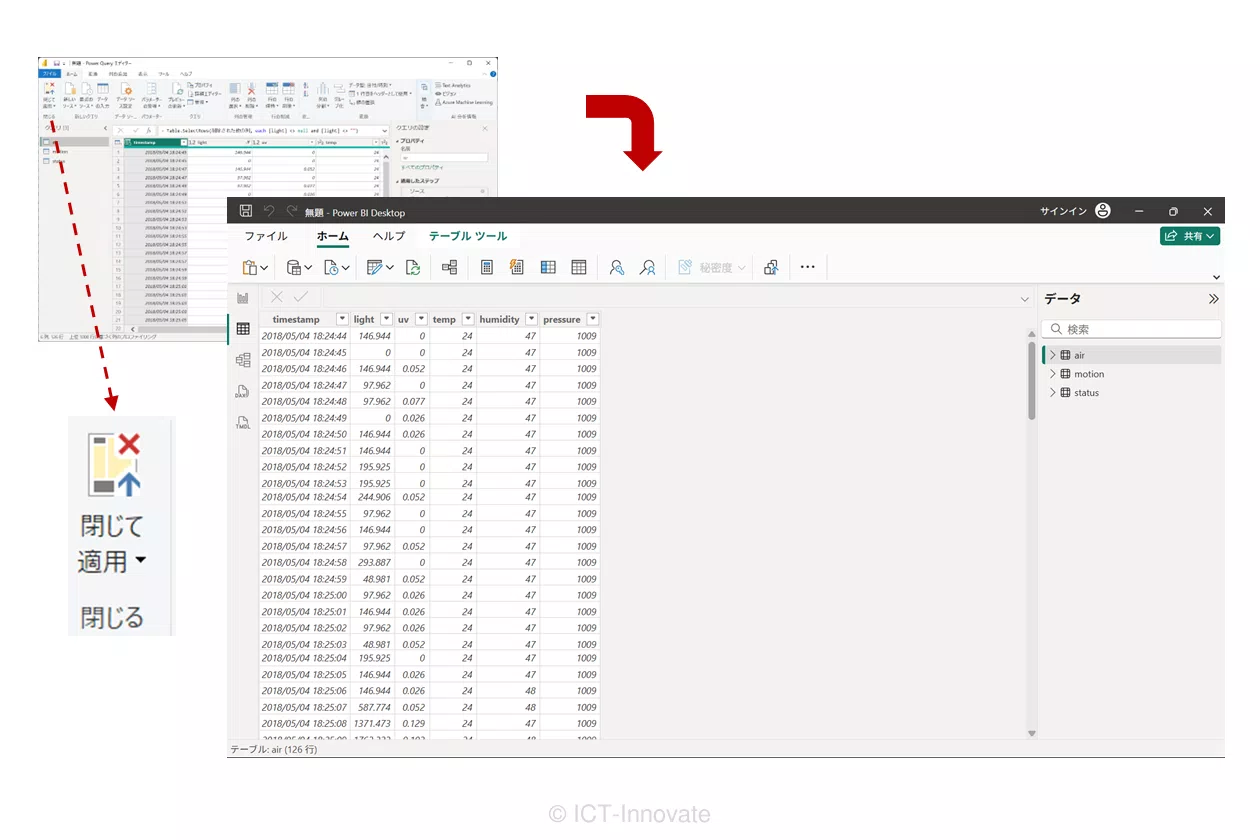

[4]「Power Query エディター」の終了

クエリ編集を終えたら「Power Query エディター」を閉じます。操作の流れは下図の通りです。

Power Query エディターを閉じることで、クエリ編集の結果はPower BI Desktop本体のデータモデルに反映されます。画面右(データ)に、空の値を含まない、分析に最適化された3つのデータテーブル(motion, air, status)が利用可能になっています。これで、当初の目的であった「虫食い状態」の解消とデータ整形が完了しました。

データ分析におけるBIツール活用のメリット

こうしたデータクリーニング結果は、Power BI Desktopのレポート作成機能を用いてグラフ作成といったデータ可視化を進めるための基盤となります。事例をご紹介した上で、Power BI DesktopのようなBIツールをデータ分析に活用するメリットについて考察します。

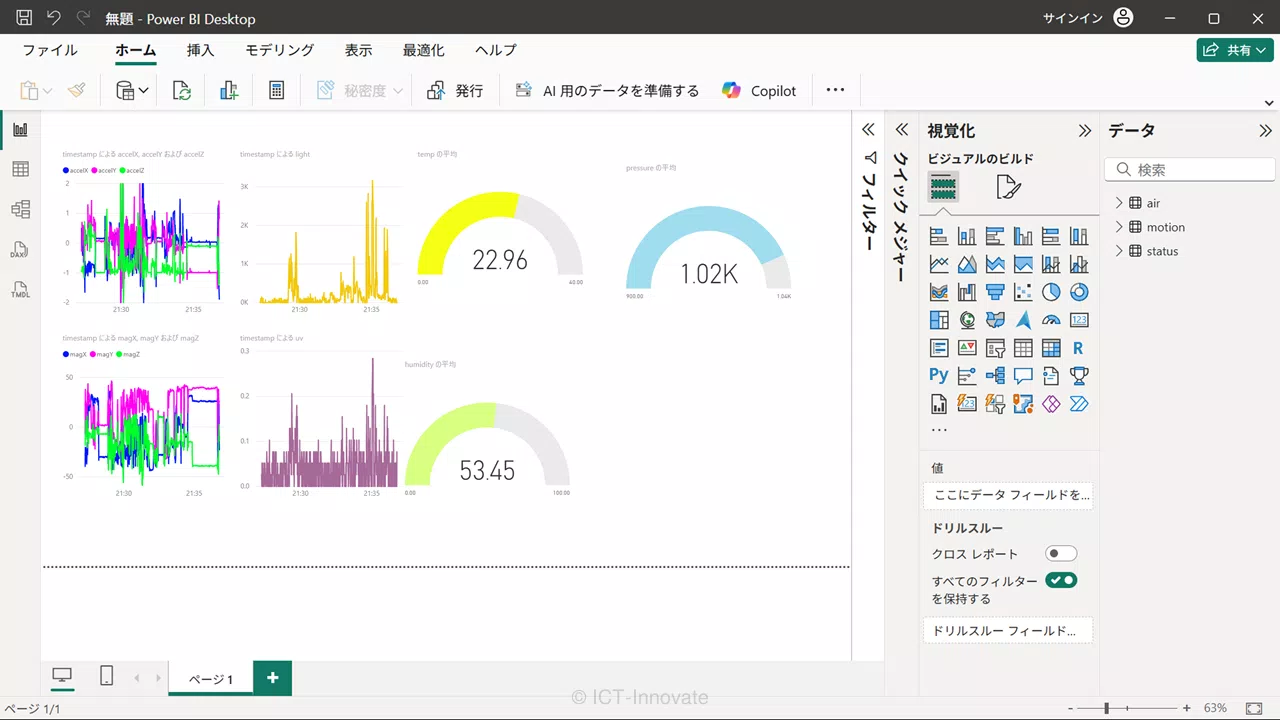

[1]可視化によるデータ分析例

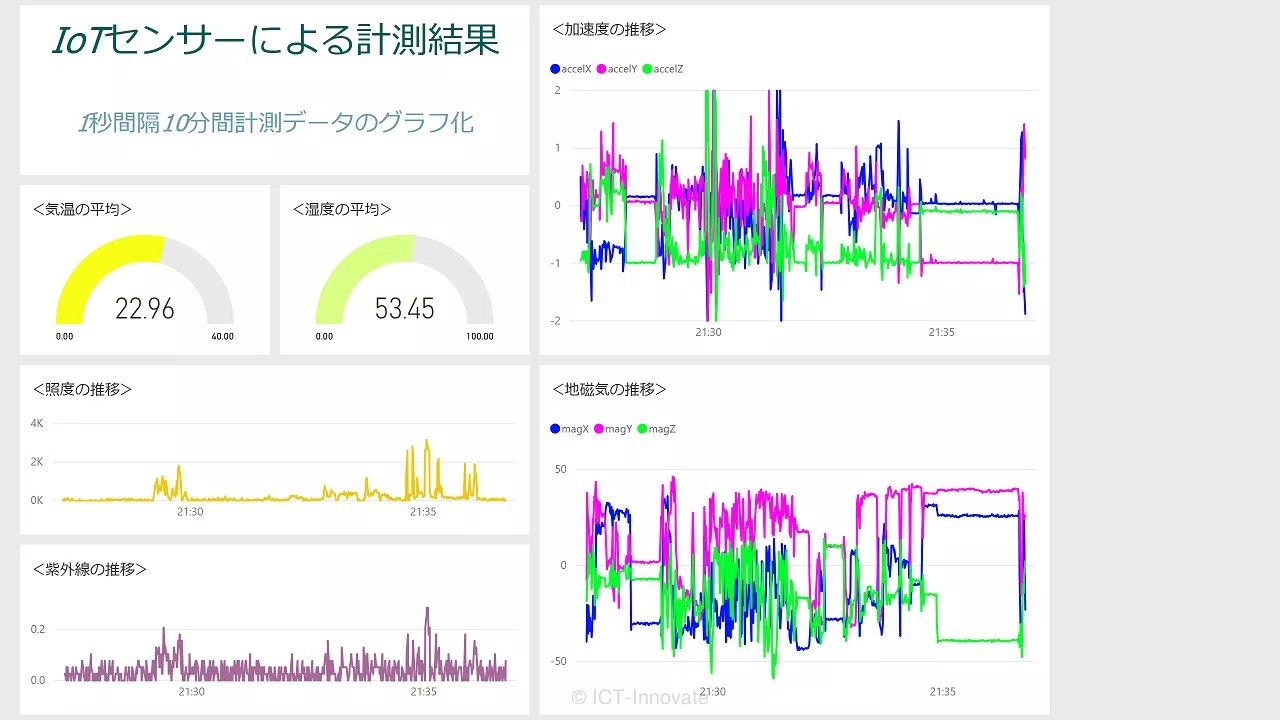

レポート作成機能により、グラフを作成してデータを可視化しました。この辺りの詳細は、チュートリアルの「レポートの作成」が該当します。下図はPower BI Desktopのレポートビューにおけるレポート作成例となります。

- 加速度、地磁気のデータから折れ線グラフを作成

- 照度、紫外線のデータから縦棒グラフを作成

- 温度、湿度、気圧のデータ(各平均値)からゲージ グラフを作成

なお、Power BI Desktopでは、個々に作成したグラフなどを全体としてストーリーを持つように配置する使い方は困難です。より優れたデザインの可視化を実現するには、Power BI サービス(クラウド)のダッシュボード機能を利用します。この辺りの詳細は、チュートリアルの「作業の共有」が該当します。下図はダッシュボード作成例となります。

[2]BIツール活用のメリット

データ分析作業におけるデータクリーニングから可視化までの実例を、Power BI Desktopを用いてご紹介しました。改めて要点を整理しましょう。

- 多種多様なソースからのデータインポートが可能であり、複数のデータソースを統合した定期的なレポート作成が容易

- インタラクティブなデータ可視化、グラフや指標の連動性が強く、視覚的にも優れており、高度な分析が可能

- Power BI サービスとの連携により、組織内外での情報共有に適しており、スケーラビリティが高い

- 一度設定・保存すればデータソースが更新されても最新のレポートを自動で作成してくれ、スケジュールされた更新にも対応

これらのメリットは、Power BI Desktopに限ったことではありません。もう少し業務寄りの視点から、BIツールを活用するメリットの例を挙げてみましょう。

データ分析のスケーラビリティの点では、例えば、時間軸を年・月・日単位で変えたり、対象範囲を全社・本社・工場A・工場Bのように切り替えたりといった操作を、ワンクリックで行うことが可能です。これにより、作成されたレポートを受け取る側が高い自由度で分析可能となります。

自動更新の点では、日々の最新データから定型的にレポートを作成しなければならない業務において、BIツールを活用することで大幅な省力化が期待できます。

このように、BIツールはデータ分析作業の前提となるデータクリーニングだけでなく、ビジネスシーンにおけるデータ活用に多くの付加価値をもたらし、上手に活用することで高い競争力を得ることに貢献します。

(補足)Excelとの使い分けを考察

当コラム記事では、Power BI Desktopを用いてデータクリーニング作業を実施しましたが、こうしたデータ操作、特に「データの取得・変換・整形・結合」は、Excelでも同様に行うことが可能になっています。これは、Power BI DesktopのPower Query エディターの基盤となっている「Power Query」が、Excelにも統合されているためです。Microsoft 365のExcelでは、「データ」タブに完全統合されており、直感的に使えるようになっています。

Power Queryは、データ変換・加工ツールです。また、データ操作に関する処理の共通エンジンとしての役割を担っています。Power Queryベースの処理が行えることにより、Power BI DesktopでもExcelでも同じ操作性でデータ操作作業を行うことができるのです。

では、データ分析を進める上で、Power BI DesktopとExcelのどちらを選択し、どのように使い分けるのが効果的でしょうか。

Power BI Desktopについては、先に整理した通り、インタラクティブなレポートやダッシュボードの作成に特化しており、データを分かりやすく可視化し、高い自由度で分析できるメリットがあります。

当コラム記事の事例のように、可視化や共有を前提としたデータ分析が目的であれば、Power BI Desktopの方がメリットが大きいと思われます。

一方でExcelは、日常業務でのきめ細やかなデータ操作や個別の分析に強みを発揮します。多くの利用者にとって直感的に操作可能であり、数式やVBAによる柔軟なカスタマイズが可能です。

筆者が実際に行っている、ExcelでのPower Query活用事例としては、全く異なる複数のソースからデータ取得し、フォーマットを揃え、一つの管理表にデータを整形し直す用途に用いています。

条件付き書式設定(セル色制御)などの細かい調整も可能ですし、整形したデータをExcelの表やピボットテーブルで分析する目的であれば、Excelの方がメリットが大きいと思われます。

ただ、どちらのツールが優れているというわけではなく、データ分析の目的と、操作を行う利用者のスキルレベルに応じて使い分けることが理想的であると言えるでしょう。

この記事のまとめ

- データ分析の成功にはデータクリーニングが不可欠であり、BIツールがその効率化を強力に支援する

- Power BI Desktopを用いた具体的な実践例を通じて、Power Queryエディターがデータ操作における強力なツールであることを実感した

- BIツールはデータ可視化、自動更新、情報共有など多岐にわたるメリットを提供し、データ活用を最大化する